Υπολογίζεται ότι έως το τέλος της δεκαετίας που διανύουμε θα δαπανηθούν σε κέντρα δεδομένων που υποστηρίζουν την Τεχνητή Νοημοσύνη περίπου 3 τρισεκατομμύρια δολάρια. Η εκτίμηση έρχεται από την επενδυτική τράπεζα Morgan Stanley, η οποία συμπληρώνει ότι περίπου το μισό του συγκεκριμένου ποσού θα αφορά δαπάνες κατασκευής ενώ το υπόλοιπο θα δαπανηθεί για τον εξοπλισμό που θα υποστηρίζει τη νέα τεχνολογία.

Το ποσό είναι αστρονομικό ειδικά αν σκεφτεί ότι τόση ήταν περίπου η αξία ολόκληρης της γαλλικής οικονομίας το 2024. Μόνο στη Βρετανία πρόκειται να κατασκευαστούν άλλα 100 κέντρα δεδομένων για να καλυφθεί η τεράστια ζήτηση για επεξεργασία τεχνητής νοημοσύνης. Μόνο η Microsoft ανακοίνωσε πρόσφατα επενδύσεις 30 δισεκατομμυρίων δολαρίων στον τομέα της τεχνητής νοημοσύνης του Ηνωμένου Βασιλείου. Άλλα 6,5 δισεκατομμύρια δολάρια θα επενδύσει στη χώρα η Google για τον ίδιο λόγο.

Όμως ποιος είναι ο λόγος που κάνει αυτά τα κέντρα δεδομένων τόσο ακριβά σε σχέση με τα «παραδοσιακά» data centers που ουσιαστικά είναι κτήρια γεμάτα διακομιστές που μέσα τους διατηρούνται οι λογαριασμοί μας στα μέσα κοινωνικής δικτύωσης, οι εφαρμογές με τις οποίες δουλεύουμε στα γραφεία μας, ακόμα και οι προσωπικές μας φωτογραφίες;

Τα κέντρα δεδομένων άλλαξαν

Αυτό που πρακτικά έχει αλλάξει είναι το μέγεθος των κέντρων δεδομένων, που έχει αυξηθεί δραματικά τα τελευταία χρόνια, σημειώνει το BBC. Η ίδια η τεχνολογική βιομηχανία επινόησε ένα νέο όρο για να περιγράψει τοποθεσίες όπου οι απαιτήσεις ισχύος ανέρχονται σε δεκάδες μεγαβάτ και όχι σε γίγαβατ: hyperscale. Δηλαδή υπερκλίμακα. Ακολούθως, εμφανίστηκε η Τεχνητή Νοημοσύνη, που ήρθε να επιτείνει το πρόβλημα βασιζόμενη σε ακριβές μονάδες επεξεργασίας, που τις περισσότερες κατασκευάζει η Nvidia.

Αυτές οι μονάδες επεξεργασίας διατίθενται σε μεγάλες καμπίνες που κοστίζουν πέρι τα 4 εκατομμύρια δολάρια η κάθε μία. Σε αυτές τις καμπίνες κρύβεται η απάντηση στο ερώτημα γιατί τα κέντρα δεδομένων Τεχνητής Νοημοσύνης διαφέρουν από τα υπόλοιπα.

Ουσιαστικά τα Μεγάλα Γλωσσικά Μοντέλα (LLM) που εκπαιδεύουν το λογισμικό Τεχνητής Νοημοσύνης πρέπει να αναλύσουν τη γλώσσα σε κάθε πιθανό μικροσκοπικό στοιχείο νοήματος. Αυτό είναι δυνατό μόνο με ένα δίκτυο υπολογιστών που λειτουργούν από κοινού και σε εξαιρετικά κοντινή απόσταση. Αυτή η εγγύτητα είναι αναγκαία γιατί κάθε μέτρο απόστασης μεταξύ δύο τσιπ προσθέτει ένα νανοδευτερόλεπτο, ένα δισεκατομμυριοστό του δευτερολέπτου, στον χρόνο επεξεργασίας.

Όπως σημειώνει το BBC, ο χρόνος αυτός δεν είναι σημαντικός, αλλά όταν αυτές οι ελάχιστες καθυστερήσεις συσσωρεύονται πρακτικά μειώνουν την απόδοση που απαιτείται για την Τεχνητή Νοημοσύνη. Έτσι, οι καμπίνες επεξεργασίας βρίσκονται ενσωματωμένες μεταξύ τους ώστε να εξαλειφθεί αυτό το στοιχείο καθυστέρησης και να δημιουργηθεί αυτό που ο τεχνολογικός τομέας αποκαλεί παράλληλη επεξεργασία, λειτουργώντας ως ένας τεράστιος υπολογιστής. Όλα αυτά ορίζουν την πυκνότητα, μια μαγική λέξη στον κλάδο της Τεχνητής Νοημοσύνης.

Η πυκνότητα εξαλείφει τα σημεία συμφόρησης στην επεξεργασία που αντιμετωπίζουν τα κανονικά κέντρα δεδομένων όταν εργάζονται με επεξεργαστές που βρίσκονται σε απόσταση αρκετών μέτρων μεταξύ τους.

Κέντρα δεδομένων και ενέργεια

Ωστόσο, αυτές οι πυκνές σειρές μονάδων επεξεργασίας καταναλώνουν τεράστια ποσά ενέργειας ενώ η εκπαίδευση των LLM παράγει πρόσθετες αιχμές σε αυτή τη ζήτηση. Αυτές οι αιχμές ισοδυναμούν με χιλιάδες σπίτια που ενεργοποιούν και απενεργοποιούν τους βραστήρες ταυτόχρονα κάθε λίγα δευτερόλεπτα, δίνει ένα χαρακτηριστικό παράδειγμα το BBC.

Αυτός ο τύπος ακανόνιστης ζήτησης σε ένα τοπικό δίκτυο πρέπει να αντιμετωπίζεται προσεκτικά. Ακριβώς όπως αυτοί οι συγχρονισμένοι βραστήρες, οι ξαφνικές εξάρσεις της τεχνητής νοημοσύνης παρουσιάζουν αυτό που οι ειδικοί αποκαλούν μοναδικό πρόβλημα. «Ο μοναδικός φόρτος εργασίας σε αυτή την κλίμακα είναι ανήκουστος», λέει στο BBC ο Ντάνιελ Μπίζο της εταιρείας συμβούλων μηχανικών κέντρων δεδομένων The Uptime Institute. «Είναι μια τόσο ακραία μηχανική πρόκληση, σαν το πρόγραμμα Apollo», σημειώνει.

Το συγκεκριμένο ενεργειακό πρόβλημα αντιμετωπίζεται με διαφορετικούς τρόπους από τον εκάστοτε φορέα εκμετάλλευσης κέντρων δεδομένων. Ο Τζένσεν Χουάνγκ της Nvidia έχει δηλώσει ότι ερισσότεροι αεριοστρόβιλοι θα μπορούσαν να χρησιμοποιηθούν «εκτός δικτύου, ώστε να μην επιβαρύνουμε τους ανθρώπους στο δίκτυο». Μάλιστα, συμπλήρωσε ότι η ίδια η AI θα σχεδίαζε καλύτερους αεριοστροβίλους, ηλιακούς συλλέκτες, ανεμογεννήτριες και ενέργεια σύντηξης για να παράγει πιο οικονομικά αποδοτική βιώσιμη ενέργεια.

Η Microsoft από την πλευρά της επενδύει δισεκατομμύρια δολάρια σε ενεργειακά έργα, συμπεριλαμβανομένης μιας συμφωνίας με την Constellation Energy που θα οδηγήσει στην επανεκκίνηση της παραγωγής πυρηνικής ενέργειας στο Θρι Μάιλ Άιλαντ. Η Alphabet, μητρική της Google, επενδύει επίσης στην πυρηνική ενέργεια στο πλαίσιο μιας στρατηγικής για λειτουργία με ενέργεια χωρίς εκπομπές άνθρακα έως το 2030. H Amazon Web Service από την πλευρά της αναφέρει ότι είναι ήδη ο μεγαλύτερος εταιρικός αγοραστής ανανεώσιμων πηγών ενέργειας στον κόσμο.

Οι περιβαλλοντικές επιπτώσεις

Ένας άλλος κρίσιμος παράγοντας είναι οι περιβαλλοντικές επιπτώσεις καθώς τεράστιες ποσότητες νερού απαιτούνται για την ψύξη των συστημάτων επεξεργασίας. Στην πολιτεία της Βιρτζίνια των ΗΠΑ, όπου υπάρχει ένας αυξανόμενος αριθμός κέντρων δεδομένων που διατηρούν σε λειτουργία τεχνολογικούς κολοσσούς όπως η Amazon και η Google, εξετάζεται ένα νομοσχέδιο που συνδέει την έγκριση νέων εγκαταστάσεων με τα στοιχεία κατανάλωσης νερού.

Εν τω μεταξύ, ένα προτεινόμενο εργοστάσιο τεχνητής νοημοσύνης στο βόρειο Λινκολνσάιρ του Ηνωμένου Βασιλείου έχει αντιμετωπίσει αντιρρήσεις από την Anglian Water, η οποία είναι υπεύθυνη για τα ύδατα στην περιοχή της προτεινόμενης τοποθεσίας. Η Anglian Water επισημαίνει ότι δεν είναι υποχρεωμένη να παρέχει νερό για μη οικιακή χρήση και προτείνει τη χρήση ανακυκλωμένου νερού από το τελικό στάδιο της επεξεργασίας λυμάτων ως ψυκτικού μέσου αντί για πόσιμο νερό.

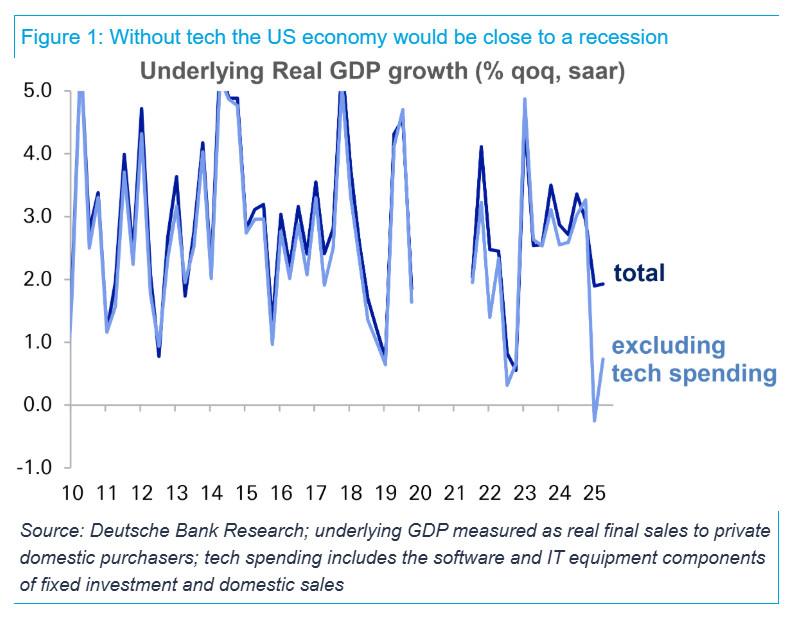

Είναι τελικά τα κέντρα δεδομένων… φούσκα;

Δεδομένων των πρακτικών προβλημάτων και του τεράστιου κόστους που αντιμετωπίζουν τα κέντρα δεδομένων τεχνητής νοημοσύνης, πολλοί είναι αυτοί που αναρωτιούνται αν το όλο θέμα είναι πραγματικά μια μεγάλη φούσκα. Ο Zahl Limbuwala, ειδικός για τα κέντρα δεδομένων στην εταιρεία συμβούλων επενδύσεων τεχνολογίας DTCP, αναγνωρίζει μεγάλα ερωτήματα σχετικά με το μέλλον των δαπανών για κέντρα δεδομένων τεχνητής νοημοσύνης.

«Είναι πολύ δύσκολο να πιστέψει κανείς την τρέχουσα πορεία του κλάδου. Αλλά οι επενδύσεις πρέπει να αποφέρουν απόδοση, αλλιώς η αγορά θα διορθωθεί από μόνη της», δηλώνει στο BBC. Έχοντας κατά νου αυτές τις προειδοποιήσεις, εξακολουθεί να πιστεύει ότι η Τεχνητή Νοημοσύνη αξίζει μια ξεχωριστή θέση όσον αφορά τις επενδύσεις. «Η Τεχνητή Νοημοσύνη θα έχει μεγαλύτερο αντίκτυπο από τις προηγούμενες τεχνολογίες, συμπεριλαμβανομένου του διαδικτύου. Επομένως, είναι εφικτό να χρειαστούμε όλα αυτά τα γιγαβάτ».

Τα κέντρα δεδομένων τεχνητής νοημοσύνης «αποτελούν την ακίνητη περιουσία του τεχνολογικού κόσμου», σημειώνει. Οι κερδοσκοπικές τεχνολογικές φούσκες, όπως η άνθηση των dotcom της δεκαετίας του 1990, δεν είχαν μια φυσική βάση. Τα κέντρα δεδομένων τεχνητής νοημοσύνης είναι πολύ σταθερά. Αλλά η άνθηση των δαπανών πίσω από αυτά δεν μπορεί να διαρκέσει για πάντα, καταλήγει.

Με δεδομένο το μέγεθος των επενδύσεων κάποιοι ήδη κάποιοι αναρωτιούνται τι θα συμβεί όταν έρθει η ώρα της αποπληρωμής.

Πηγή: ot.gr